Si alguna vez te han devuelto respuestas que “suenan a máquina”, imágenes que no respetan el brief o código difícil de mantener, te adelanto algo: el problema no es la IA; es el pedido. En mi día a día he visto que el problema casi nunca es la herramienta, sino el prompt. Por eso hoy vamos directo al grano: cómo crear buenos prompts que conviertan ideas difusas en entregables claros y utilizables.

Muchos prompts fallan porque piden “algo” sin decir quién lo pide, para qué lo necesita ni cómo se evaluará el resultado. Aquí vas a aprender qué es un prompt, cómo aplicar prompt engineering (ingeniería de prompts) en lenguaje llano y cuál es la estructura de un prompt que realmente funciona—con ejemplos de prompts listos para copiar y una decisión práctica sobre prompts en español o prompts en inglés según el caso. Desde artículos de marketing hasta depuración de código y prototipado de diseño: saldrás con plantillas, checklist de verificación y reglas simples para iterar con confianza.

Qué es un prompt y qué no es

Un prompt es una instrucción estructurada que da a la IA el contexto, la tarea y los criterios para producir una salida útil. No es una descripción vaga ni una súplica creativa al azar. Un buen prompt se parece más a un brief: define rol, objetivo, audiencia, formato de entrega y cómo sabremos si el resultado está bien.

Lo que NO es un buen prompt

- “Escríbeme un artículo sobre marketing.”

- “Haz un logo bonito.”

- “Arréglame este código.”

Por qué fallan: carecen de rol, parámetros, formato y criterios de calidad. Cuando pido formato de salida, tono y criterios de evaluación, la IA deja de ser caja negra y actúa como colaborador.

Prompt, ejemplos simples

Veamos una transformación rápida (antes → después):

- Antes: “Escríbeme un artículo sobre newsletters.”

- Después: “Actúa como consultor de email marketing senior.

Objetivo: guiar a un freelancer que quiere duplicar su CTR en 60 días.

Crea un artículo de 1200–1500 palabras con tono cercano-profesional, estructura H2/H3, 3 casos prácticos y checklist final.

Evalúo calidad por: claridad, aplicabilidad y ejemplos medibles. Devuélvelo en Markdown.” - Antes: “Genera un logo para una app de finanzas.”

- Después (imagen): “Eres director creativo. Diseña 4 propuestas de logo para una app de finanzas personales dirigida a Gen Z, valores: transparencia y alegría. Paleta base #1E90FF y #FFD166; evita símbolos de dólar. Entrega conceptos con descriptores visuales (forma, peso tipográfico, geometría) y una nota de uso en fondos oscuros/claros.”

En mi experiencia, cuando defino la audiencia (“Gen Z”), el tono (“cercano-profesional”), el formato (Markdown, tabla, JSON) y la métrica de calidad (CTR, claridad, reusabilidad), las respuestas dejan de ser genéricas.

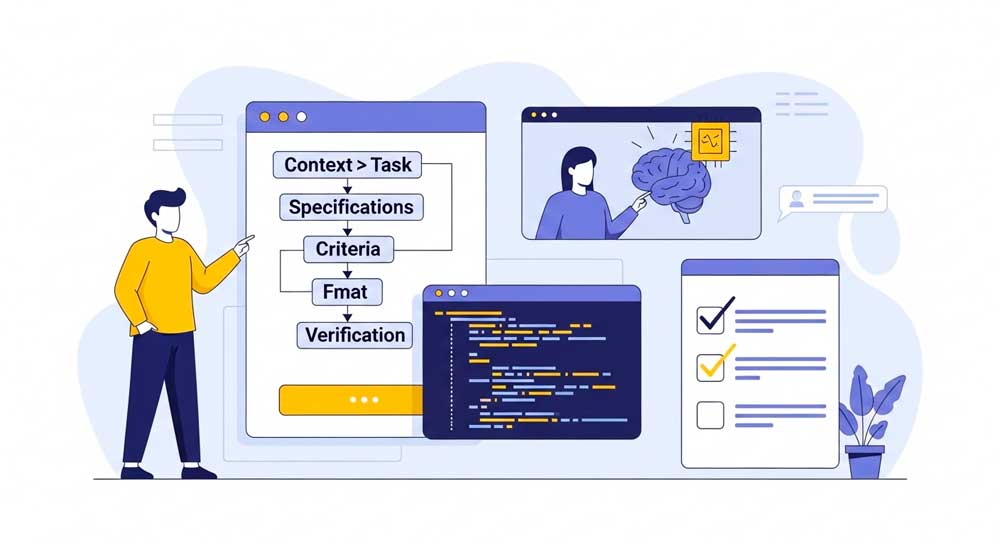

Estructura de un prompt eficaz

contexto/rol → tarea → especificaciones → criterios de calidad → formato → verificación

Contexto/rol

Explica quién eres y en qué situación estás. “Actúa como… consultor SEO / PM / profesor / revisor de código”.

Tarea

Di exactamente qué necesitas: “redacta…”, “propón…”, “depura…”, “genera 3 variantes…”.

Especificaciones

Audiencia, tono, restricciones, fuentes, ejemplos, límites (tiempo, palabras, estilos), supuestos válidos.

Criterios de calidad (definición de “bien hecho”)

Cómo evaluarás el resultado: precisión, cobertura del tema, originalidad, legibilidad, reusabilidad del código, coherencia visual, etc.

Formato de respuesta

Markdown, tabla, JSON, pasos numerados, snippet de código listo para copiar, etc.

Verificación

Pide auto-chequeo: “confirma supuestos”, “detecta riesgos”, “propón una mejora”, “señala límites”.

Plantilla base (copiable)

[Contexto/Rol] Actúa como {rol} para {audiencia/escenario}.

[Tarea] {qué necesitas exactamente} con {alcance/objetivo}.

[Especificaciones] Tono {x}, longitud {y}, incluye {secciones/listas/ejemplos}, usa {datos/estándares}, evita {errores/temas}.

[Criterios de calidad] Evaluaré por {métricas/criterios}, peso relativo {ej.: claridad 40%, precisión 40%, originalidad 20%}.

[Formato] Devuelve en {Markdown/tabla/JSON/código} con {estructura concreta}.

[Verificación] 1) Resume supuestos. 2) Señala 2 riesgos. 3) Propón 1 mejora. 4) Marca lo que falta para “publicable”.

Tip práctico: Si el resultado no cumple, no cambies de herramienta; itera el prompt adjuntando ejemplos (few-shot) y una checklist de correcciones. Yo suelo iterar con 1–2 ejemplos y el salto de calidad es inmediato.

Prompt engineering / ingeniería de prompts en cristiano

¿Qué es prompt engineering (ingeniería de prompts)?

Disciplina que diseña, estructura y evalúa instrucciones para modelos de IA con el fin de obtener salidas fiables, útiles y reproducibles. Combina brief claro (rol, objetivo, restricciones), ejemplos guía, formato de salida y verificación, y se itera con métricas de calidad.

Objetivos clave

- Reducir ambigüedad y alucinaciones.

- Aumentar calidad, consistencia y reusabilidad de la salida.

- Hacer el proceso medible (criterios y checklist).

Técnicas núcleo (en lenguaje llano)

- Few-shot: muestra 1–3 ejemplos de “esto es lo que quiero”.

- Instrucciones negativas: “evita X, no inventes Y”.

- Razonamiento guiado: divide la tarea en pasos (bosquejo → desarrollo → verificación).

- RAG (con fuentes): aporta fragmentos/“docs” y exige usarlos y citarlos.

- Esquemas de salida: pide Markdown/tabla/JSON con campos fijos.

- Auto-chequeo: que el modelo resuma supuestos, riesgos y mejoras.

Qué NO es

- No es “escribir bonito”. Es diseño sistemático de instrucciones + evaluación.

Zero-shot vs Few-shot

- Zero-shot: pides sin ejemplos. Rápido, pero más variable.

- Few-shot: incluyes 1–3 ejemplos de entrada→salida. El modelo capta estilo y estructura con menos ambigüedad. Cuando quiero “voz humana”, incluyo un ejemplo de tono y un contraejemplo de lo que NO quiero.

Instrucciones explícitas y negativas

- Pide lo que quieres y lo que no (“evita clichés”, “no repitas la introducción”, “no inventes datos”).

- Usa reglas: “si no sabes, di ‘no lo sé’ y sugiere fuentes”.

Cadena de pensamiento (razonamiento guiado)

No hace falta pedir “piensa paso a paso” de forma literal; puedes solicitar subtareas: “Primero lista supuestos, luego bosqueja estructura, después desarrolla con ejemplos y al final verifica”.

RAG (cuando aplicable)

Si necesitas hechos actualizados o específicos, provee extractos y exige citas. “Solo usa los fragmentos adjuntos. Si falta info, dilo.”

Control de estilo

Define tono (“desenfadado con autoridad”), persona (“primera persona”), y ritmo (párrafos cortos, listas, ejemplos). En mi caso, esto elimina el “sonido a máquina” el 90% de las veces.

Manejo de ambigüedad

Solicita que la IA pregunte 3 aclaraciones si detecta huecos críticos antes de ejecutar. Ahorra iteraciones y evita respuestas fuera de contexto.

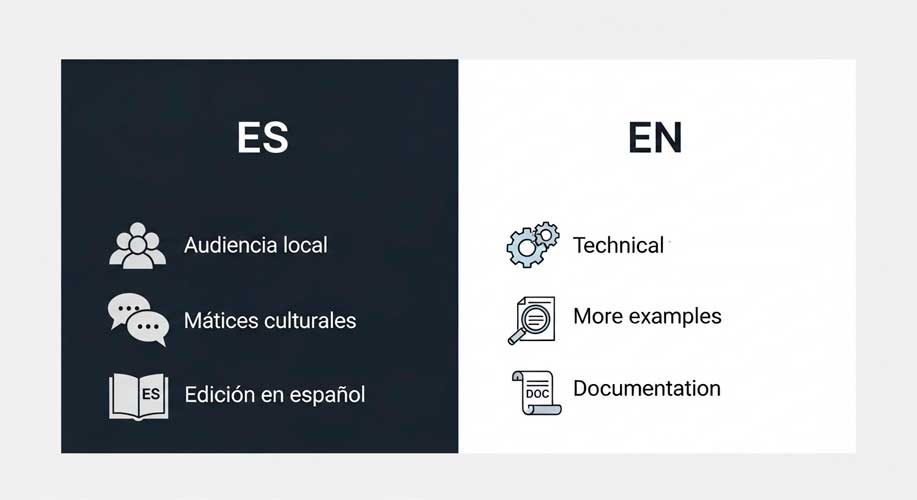

¿Prompts en español o en inglés? Ventajas, riesgos y reglas claras

Cuándo usar español

- Audiencia hispanohablante, matices culturales/lingüísticos importantes.

- Evaluación humana por equipo en español.

- Textos con ejemplos locales (legislación, expresiones, referencias).

Cuándo usar inglés

- Documentación técnica o APIs con terminología inglesa predominante.

- Búsqueda de mayor volumen de ejemplos técnicos (sobre todo en código).

- Cuando notas mejores resultados estilísticos o más variedad de sinónimos.

Reglas prácticas

- Pide en el idioma del entregable final. Si publicarás en español, promt en español y pide “no traduzcas anglicismos innecesarios”.

- Si mezclas idiomas, sé explícito: “Razona en inglés pero redacta en español neutro”.

- Comprueba matices: solicita “revisión de localización” (tuteo/ustedeo, regionalismos).

- Traducción con preservación de estilo: “Traduce manteniendo el registro, evita literalidad y conserva la intención persuasiva.”

Ejemplos de prompts por objetivo

(todos listos para copiar y adaptar)

Marketing de contenidos

Actúa como estratega de contenidos para una marca B2B SaaS de analítica. Objetivo: un artículo 1500 palabras que enseñe a elegir KPIs de producto. Tono cercano-profesional, ejemplos con métricas. Incluye 3 estudios de caso y una tabla comparando KPI vs métrica de vanidad. Evalúo por claridad (40%), aplicabilidad (40%), originalidad (20%). Entrega en Markdown con H2/H3, bullets y conclusión accionable. Verifica: supuestos, 2 riesgos, 1 mejora.

Campañas en redes sociales

Eres copy senior de paid social. Genera 5 conceptos de anuncio para una app de salud mental (18–30 años), objetivo: descargas. Formato: para cada concepto, 1 ángulo creativo, 2 copys cortos, 1 CTA, 3 variantes de titular y 1 sugerencia visual. Estilo empático, evita “promesas milagro”. Mide calidad por claridad del beneficio y coherencia tono-visual. Devuelve en tabla.

Prototipado de UI

Actúa como UX writer. Redacta microcopys para el onboarding de una app de educación financiera: 5 pantallas, tono didáctico. Para cada pantalla: título (≤40 caracteres), subtítulo (≤80), botón primario/secundario y texto de ayuda. Incluye nota de accesibilidad (contraste y ARIA). Devuelve en JSON.

Depuración de código

Eres revisor de código en Python. Te paso una función que falla intermitentemente. Tarea: detectar 3 posibles causas, proponer refactor y tests unitarios. Criterios: legibilidad, complejidad ciclomática baja, cobertura de tests ≥90%. Devuelve: 1) explicación paso a paso, 2) snippet refactorizado, 3) archivo de tests. Verifica supuestos y límites.

Cuando probé a pedir formato en tabla o JSON, el equipo técnico agradeció la reusabilidad: copiar-pegar sin pérdidas y con campos bien definidos.

Checklist de verificación y evaluación de calidad (antes de entregar)

Verificación rápida (para cualquier prompt)

- ¿Definí rol y contexto?

- ¿La tarea es inequívoca?

- ¿Puse especificaciones (audiencia, tono, restricciones)?

- ¿Dejé claros criterios de calidad medibles?

- ¿Fijé formato de respuesta explotable (Markdown/tabla/JSON/código)?

- ¿Pedí verificación (supuestos, riesgos, mejoras)?

- ¿Incluí 1–2 ejemplos si la salida depende de estilo?

Métricas sugeridas para textos

- Claridad (0–10), Cobertura del tema (0–10), Originalidad (0–10), Consistencia de tono (0–10).

Para código - Complejidad, legibilidad, cobertura de tests, manejo de errores.

Para imágenes/diseño - Coherencia con brief, legibilidad, contraste, adaptabilidad a formatos.

Mini-A/B test del prompt

Pide 2 variantes: V1 (breve) vs V2 (con few-shot). Compara tiempo de edición humana y tasa de “publicable sin retoques”. Yo suelo quedarme con la versión que reduce más la edición.

Errores frecuentes y cómo iterar hasta un resultado “publicable”

Errores típicos

- Pedir “ideas” sin objetivo ni audiencia.

- No definir tono ni formato de salida.

- No incluir criterios de calidad (¿cómo sabes si está bien?).

- No exigir verificación: la IA no te dirá sola lo que falta.

Cómo arreglarlo en 2 rondas

Ronda 1: añade rol, objetivo y formato.

Ronda 2: agrega ejemplos (few-shot) y checklist de evaluación.

En mi caso, con estas dos rondas el salto es visible: desaparecen los clichés y los entregables salen listos para producción o con mínimos ajustes.

Plantillas copiables y consejos para escalar tu flujo

Plantilla breve (cuando vas con prisa)

Rol: {quién eres}. Objetivo: {qué impacto buscas}.

Tarea: {acción específica}.

Especificaciones: {audiencia, tono, límites, ejemplos}.

Calidad: {criterios y pesos}.

Formato: {Markdown/tabla/JSON/código}.

Verificación: {supuestos, riesgos, 1 mejora}.

Plantilla para prompts técnicos (código/datos)

Actúa como {rol técnico}. Recibirás {contexto/datos/código}.

Tarea: {diagnóstico/refactor/consulta}.

Requisitos: {estándares, dependencias, estilos}.

Calidad: {complejidad, rendimiento, pruebas}.

Entrega: {snippets, tests, pasos}.

Verificación: {edge cases, límites, seguridad}.

Consejos para escalar

- Construye una biblioteca por caso de uso (marketing, UX, data, código).

- Versiona prompts con notas de “qué funcionó” y “qué recortar”.

- Automatiza plantillas en tu herramienta favorita y bloquea formato (siempre tabla/JSON).

- Revisa cada 2–4 semanas: la mejoría viene de iterar, no de inventar desde cero.

Conclusión

Crear grandes resultados con IA no es magia: es método. Define rol y contexto, concreta la tarea, especifica parámetros y restricciones, fija criterios de calidad, obliga un formato de salida utilizable y cierra con verificación. Con esta estructura—y algunas técnicas sencillas de ingeniería de prompts—pasas de pedir “algo” a dirigir a un colaborador experto. Y sí: cómo crear buenos prompts es una habilidad que mejora con práctica y con una biblioteca de ejemplos vivos.

FAQs

¿Qué es un prompt?

Es la instrucción estructurada que das a la IA con contexto, tarea, criterios y formato para producir una salida útil.

¿Cuál es la estructura de un prompt eficaz?

Contexto/rol → tarea → especificaciones → criterios de calidad → formato → verificación.

¿Prompts en español o en inglés?

En el idioma del entregable. Usa inglés para documentación técnica cuando te dé mejores ejemplos; valida localización al final.

¿Qué es prompt engineering?

Conjunto de técnicas para diseñar prompts que guían a la IA: few-shot, instrucciones negativas, razonamiento por pasos, RAG, control de estilo y verificación.

¿Cómo logro que no “suene a máquina”?

Incluye ejemplos de tono (y anti-ejemplos), define audiencia y pide revisión de estilo con reglas claras.